L’intelligence artificielle au service des tests : une adoption en forte croissance, encore freinée par des obstacles structurels

Les activités de test représentent en moyenne 20 à 30 % du coût total d’un projet, constituant ainsi un levier essentiel de performance et de maîtrise des risques pour les organisations. Pourtant, malgré cet investissement conséquent, chaque mise en production s’accompagne encore d’une hausse significative du nombre d’anomalies en exploitation, traduite par un taux de fuite souvent supérieur aux attentes.

Face à ce constat, l’intelligence artificielle s’impose progressivement comme un catalyseur majeur de transformation dans le domaine du test logiciel.

Déjà, près d’un tiers des organisations déclarent avoir intégré des solutions d’IA à leurs pratiques, principalement pour :

- L’automatisation des tests

- La génération de jeux de données

- L’optimisation des tests de performance.

Cependant, cette adoption reste encore freinée par plusieurs obstacles structurels :

- Un niveau d’investissement élevé, souvent lié au poids de l’historique technologique et organisationnel

- Une maturité encore inégale des outils disponibles sur le marché

- Une qualité des données parfois insuffisante pour permettre aux modèles et assistants IA d’atteindre leur plein potentiel.

La tendance de fond est néanmoins irréversible : l’intelligence artificielle s’installe durablement dans les pratiques de test. Son impact réel, toutefois, dépendra de la capacité des organisations à industrialiser, fiabiliser et piloter ces approches de manière structurée — condition indispensable pour en exploiter toute la puissance au service de la qualité et de la performance logicielle.

Premiers constats, potentiel et limites de l’IA pour les tests

L’intelligence artificielle s’impose aujourd’hui comme un puissant levier d’optimisation des activités de test.

Elle permet d’automatiser la génération et la planification des cas de test, de prioriser les campagnes en fonction des risques et de la criticité, et d’analyser intelligemment les résultats en détectant, qualifiant ou catégorisant les anomalies.

Grâce à ses capacités prédictives et analytiques, l’IA améliore la couverture de test, réduit les redondances, accélère les cycles et facilite la production de bilans et de retours d’expérience.

En somme, elle renforce l’efficacité opérationnelle et la fiabilité globale des processus de test, notamment sur les tâches à forte intensité de données ou à logique répétitive.

Cependant, l’IA montre encore ses limites dès qu’il s’agit de compréhension fine du contexte métier, d’arbitrages stratégiques ou de recommandations contextualisées.

Elle peine à interpréter les résultats en fonction d’enjeux fonctionnels, à proposer des ajustements pertinents dans les plans de test, ou à produire un reporting narratif et décisionnel.

De même, la gestion des ressources, des environnements ou la résolution concrète des anomalies restent largement humaines.

De nombreux cas d’usage envisageables

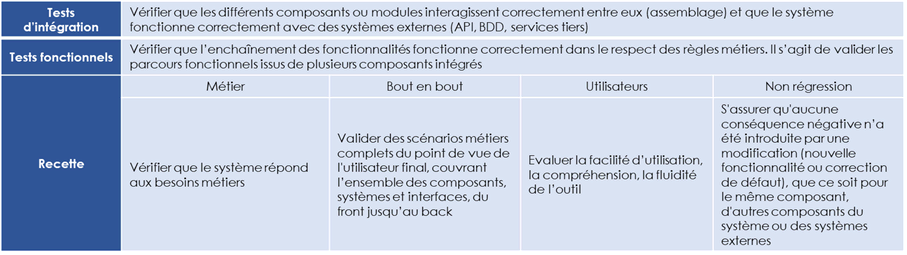

A ce stade de l’évolution des outils et pratiques de tests et de la maturité des moteurs d’Intelligence artificielle, le périmètre qui nous semble le plus accessible pour obtenir des gains rapides est celui des tests fonctionnels (en opposition aux tests unitaires conduits par les développeurs ou aux tests non fonctionnels – performance, sécurité, exploitabilité, résilience – qui vont demander un outillage plus pointu et spécifique). Nous le définissons comme suit :

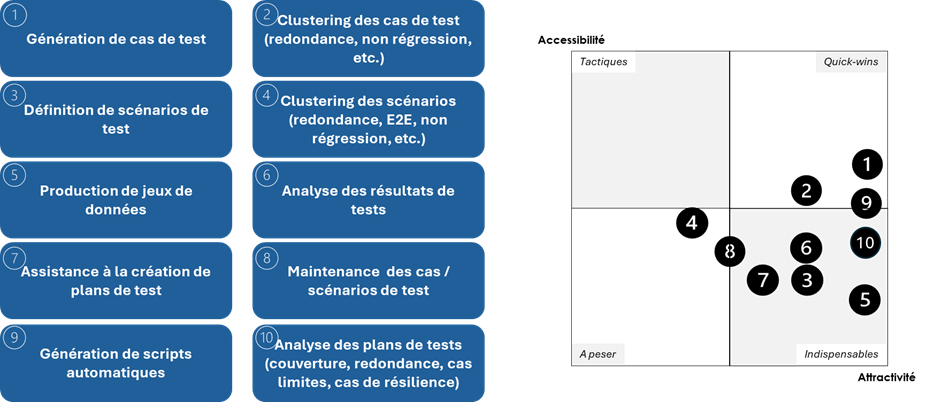

Une fois ce périmètre définit, les cas d’usages suivants nous semblent les plus prometteurs avec des niveaux d’accessibilité et d’attractivité différents :

La pertinence de ces cas d’usage varie de manière significative en fonction des « modèles de delivery » ayant cours dans l’entreprise :

- Si on adresse un périmètre en « déploiement continu », l’objectif recherché sera d’accélérer et fiabiliser des tests incrémentaux pour suivre le rythme de livraison. On s’intéressera alors en particulier à la génération de cas de tests, le self-healing, l’identification de tests de non-régression, la génération automatique de scripts et l’analyse des résultats de tests afin d’automatiser au maximum l’effort de test et de l’intégrer dans une chaine de CI/CD

- Sur un périmètre en livraisons itératives (features toutes les 2 à 4 semaines), on ajoutera la définition de scenarios de tests afin d’adresser les parcours de bout en bout et les zones les plus à risque

- Sur un périmètre de livraison par version avec de gros incréments livrés sur des bases

- plurimensuelles, il sera pertinent d’enrichir encore avec l’optimisation des plans de tests (couverture, redondance, cas limites, cas de résilience) et la maintenance du référentiel de tests, dans une logique de mise en qualité complète avant mise en production d’une version (homologation).

Tirer la quintessence de l’IA : la qualité des données comme première étape essentielle

L’idée selon laquelle l’intelligence artificielle serait capable, par elle-même, de générer des cas de tests et des jeux de données parfaitement pertinents à partir d’une base hétérogène de besoins fonctionnels relève encore largement du mythe.

En réalité, sans un minimum de guidage, l’IA risque de mal interpréter les informations disponibles et de commettre de nombreux contresens sur le besoin métier — surtout lorsque celui-ci est exprimé de manière dispersée et incohérente dans différents documents sans lien logique explicite.

Il convient donc de considérer l’intelligence artificielle non pas comme un outil magique, mais comme un agent capable de produire de la valeur à partir d’une base documentaire solide, structurée et cohérente.

Dans ce contexte, l’IA devient un véritable levier pour générer les éléments nécessaires à une couverture de test exhaustive et efficace d’un cœur applicatif, tout en étant capable d’extrapoler cette logique vers de nouvelles fonctionnalités ou de nouveaux écrans.

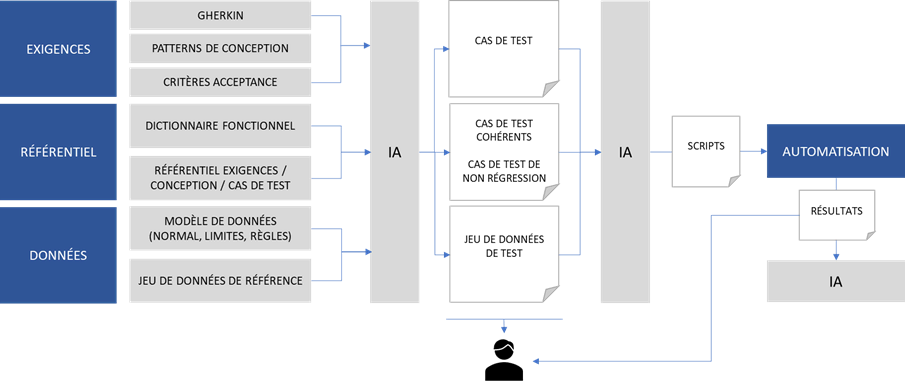

Pour exploiter pleinement ce potentiel, un travail de fond est indispensable en amont de l’utilisation de l’IA, afin de lui fournir les éléments d’entrée nécessaires à la compréhension de la logique métier et à la génération rapide de cas de tests et jeux de données pertinents et bien formatés.

Cela implique notamment de :

- Normer les exigences et les spécifications fonctionnelles, par exemple en recourant à un framework de type Gherkin, et d’y associer des patterns de conception et des critères d’acceptation clairs ;

- Enrichir la base documentaire dans une approche référentiel en organisant la capitalisation et le partage des documents d’exigences, de spécifications / user stories / epics, de règles métier et de plans de test passés ;

- Décrire de manière précise les modèles de données, les règles métier et en intégrant des jeux de données de référence permettant d’ancrer la compréhension de l’IA dans un cadre cohérent.

Une fois cette étape franchie, il devient envisageable d’alimenter une seconde IA avec les éléments produits, dans le but de générer automatiquement des scripts de tests exploitables par les outils d’automatisation.

Résultat : une élévation progressive de la qualité des livrables produits en sortie de chaîne, et une IA réellement au service de la fiabilité et de l’efficacité des processus de test.

Une seconde étape : vers une IA qui optimise la charge de test dans une logique dynamique

Une fois la chaîne de génération et de structuration des tests mise en place, l’intelligence artificielle peut être mobilisée en aval pour analyser les résultats et optimiser la stratégie de test. Cette approche s’appuie sur plusieurs leviers d’amélioration continue :

- L’échantillonnage intelligent des cas de tests, basé sur une logique de combinatoire optimisée tenant compte des différents paramètres à vérifier ;

- Le croisement des zones de test les plus pertinentes, en fonction des anomalies identifiées ou de l’incidentologie observée dans le système ;

- La priorisation des cas de test, en évaluant la probabilité d’occurrence afin de sécuriser en priorité les parcours métiers les plus critiques ou les plus fréquents.

Ces capacités offrent un double avantage : réduire la charge de test tout en préservant, voire en améliorant, la qualité de couverture fonctionnelle. Elles permettent ainsi d’accélérer les cycles de livraison sans compromettre la fiabilité du produit.

Cette évolution remet profondément en question la gestion traditionnelle et statique des campagnes de tests. Jusqu’à présent, celles-ci étaient majoritairement pilotées via des indicateurs de progression (taux de préparation, d’exécution, de couverture fonctionnelle), définis selon un périmètre figé au démarrage du projet.

L’approche « dynamique » portée par l’IA transforme cette logique : le système devient capable d’ajuster en continu les cas de test d’un cycle à l’autre, en tenant compte des résultats obtenus, de la redondance de certains scénarios, de leur fréquence d’apparition, de leur utilité réelle, mais aussi de la qualité et de la fiabilité des jeux de données associés.

Cette capacité d’adaptation fait émerger un pilotage intelligent et auto-apprenant du test logiciel, où la stratégie évolue au rythme du produit, des usages et des risques observés.

Des rôles et responsabilités à redéfinir à l’ère de l’IA pour les tests

À mesure que les solutions d’intelligence artificielle s’intègrent dans les processus de tests, les rôles et responsabilités des acteurs impliqués dans les tests fonctionnels doivent évoluer.

L’IA ne remplace pas les équipes : elle redessine la chaîne de valeur du test en redistribuant les tâches entre l’humain et la machine, et en créant de nouveaux besoins de pilotage, d’interprétation et de gouvernance.

Ainsi, de nouveaux équilibres se mettent en place entre les différents profils :

- Les responsables de tests verront leur rôle s’enrichir. Ils devront apprendre à interpréter et exploiter les nouveaux indicateurs issus du travail de l’IA afin d’optimiser les phases de test, tout en orchestrant la répartition des tâches entre les actions automatisées et celles nécessitant une intervention humaine.

- Les testeurs fonctionnels deviendront des garants de la qualité des productions de l’IA. Leur mission consistera à valider les cas générés, à superviser le comportement des outils d’intelligence artificielle et à s’assurer de la pertinence des résultats.

- Les Product Owners et Business Analysts seront appelés à jouer un rôle accru dans la définition des critères de validation et de pilotage par la valeur. Leur expertise métier permettra de guider l’IA vers une meilleure compréhension des priorités fonctionnelles et des scénarios à fort impact utilisateur.

- Les développeurs, enfin, devront intégrer plus étroitement les apports de l’IA dans leur travail quotidien, notamment à travers l’analyse automatisée des logs et des retours de tests, afin d’adapter leur code, corriger plus rapidement les anomalies et réduire le risque d’introduire de nouveaux bugs.

En somme, l’IA ne se substitue pas aux métiers du test : elle redéfinit leur posture et renforce leur rôle stratégique dans un écosystème de développement de plus en plus intelligent, agile et orienté valeur.

Pour conclure

L’intelligence artificielle s’impose progressivement comme un catalyseur majeur de transformation des pratiques de test fonctionnel.

Si les gains potentiels en matière de productivité, d’agilité et de couverture sont significatifs, leur concrétisation repose sur une double exigence : une structuration rigoureuse des entrants métiers en amont (exigences fonctionnelles, référentiels, données), et une capacité des organisations à repenser leur approche de test dans une logique itérative, dynamique et pilotée par les données.

Au-delà des outils, c’est bien un changement de paradigme qui s’annonce. Il implique l’évolution des rôles, une répartition repensée entre humain et machine, mais aussi un engagement méthodologique sur l’ensemble de la chaîne qualité.

L’IA, loin de remplacer l’expertise humaine, agit comme un accélérateur lorsqu’elle est alimentée, encadrée et valorisée de manière cohérente.

Les premiers cas d’usage déployés montrent que les bénéfices sont réels et tangibles, en particulier sur les périmètres à forte volumétrie ou aux livraisons fréquentes.

Pour en exploiter pleinement le potentiel, les organisations doivent désormais franchir une nouvelle étape : sortir de l’expérimentation opportuniste pour entrer dans une phase d’industrialisation maîtrisée et durable.

Boostez vos tests avec l’IA : Gagnez en efficacité, réduisez vos coûts et valorisez vos pratiques existantes

Des premiers résultats en 3 à 6 mois qui s’inscrivent dans la durée grâce à notre approche.